W dzisiejszym cyfrowym świecie, gdzie dane stanowią podstawę działalności większości organizacji, skuteczna strategia tworzenia kopii zapasowych jest kluczowa dla zapewnienia ciągłości działania i bezpieczeństwa informacji. Różnorodność dostępnych metod backup-u pozwala na dostosowanie rozwiązań do specyficznych potrzeb każdej organizacji, od małych firm po duże korporacje. Analiza dostępnych technologii wskazuje na fundamentalne znaczenie wyboru odpowiedniego typu kopii zapasowej w kontekście czasu wykonania, wymaganej przestrzeni dyskowej, szybkości odzyskiwania danych oraz kosztów całego procesu. Współczesne podejście do ochrony danych obejmuje nie tylko tradycyjne metody jak pełne, przyrostowe i różnicowe kopie zapasowe, ale również zaawansowane rozwiązania takie jak ciągła ochrona danych czy strategia 3-2-1, które zapewniają maksymalny poziom bezpieczeństwa informacji. Ewolucja technologii przechowywania danych, od tradycyjnych bibliotek taśmowych po nowoczesne rozwiązania chmurowe, oferuje organizacjom szerokie spektrum możliwości dostosowania strategii backup-u do ich unikalnych wymagań biznesowych i technicznych.

Podstawowe rodzaje kopii zapasowych

Fundamentem każdej strategii ochrony danych jest zrozumienie podstawowych typów kopii zapasowych i ich charakterystycznych właściwości. Wybór odpowiedniego typu backup-u zależy od wielu czynników, w tym od wielkości organizacji, krytyczności danych, dostępnych zasobów oraz wymagań dotyczących czasu odzyskiwania. Każdy typ kopii zapasowej ma swoje unikalne zalety i ograniczenia, które należy starannie rozważyć przy projektowaniu strategii ochrony danych.

Pełne kopie zapasowe

Pełna kopia zapasowa stanowi najbardziej kompletną i najprostszą formę zabezpieczenia danych, obejmując całkowite skopiowanie wszystkich informacji z systemu źródłowego na wybrany nośnik przechowywania. Proces ten polega na przeniesieniu wszystkich plików, katalogów i systemowych danych bez względu na to, czy zostały one zmodyfikowane od czasu ostatniej kopii zapasowej. Charakterystyczną cechą pełnego backup-u jest jego samowystarczalność – pojedyncza kopia zawiera wszystkie niezbędne dane do kompletnego odtworzenia systemu w stanie z momentu jej utworzenia.

Główną zaletą pełnych kopii zapasowych jest prostota procesu odzyskiwania danych, który wymaga jedynie przywrócenia tej jednej kopii bez konieczności łączenia wielu backup-ów. Ta właściwość czyni pełne kopie idealnymi w sytuacjach wymagających szybkiego i bezproblemowego odtworzenia całego systemu po poważnej awarii. Dodatkowo, pełne kopie zapasowe zapewniają najwyższy poziom niezawodności, ponieważ nie są zależne od integralności innych kopii zapasowych, co eliminuje ryzyko utraty danych w przypadku uszkodzenia jednego z elementów łańcucha backup-ów.

Jednakże pełne kopie zapasowe wiążą się z istotnymi ograniczeniami, szczególnie w kontekście zasobów wymaganych do ich utworzenia i przechowywania. Proces tworzenia pełnej kopii jest najbardziej czasochłonny ze wszystkich metod backup-u, często trwając nawet dziesięć razy dłużej niż metody alternatywne. Znaczne zapotrzebowanie na przestrzeń dyskową stanowi kolejne wyzwanie, szczególnie dla organizacji dysponujących dużymi wolumenami danych. Te ograniczenia sprawiają, że pełne kopie zapasowe są zazwyczaj wykonywane okresowo, najczęściej raz w tygodniu lub miesiącu, jako fundament szerszej strategii backup-u wykorzystującej również inne typy kopii zapasowych.

Współczesne implementacje pełnych kopii zapasowych często wykorzystują techniki kompresji i deduplikacji w celu optymalizacji wykorzystania przestrzeni dyskowej. Deduplikacja eliminuje powtarzające się fragmenty danych, znacząco redukując rozmiar kopii zapasowej bez wpływu na jej kompletność. Te technologie pozwalają na zachowanie zalet pełnych kopii zapasowych przy jednoczesnym ograniczeniu ich głównych wad, czyniąc je bardziej praktycznymi dla szerszego spektrum zastosowań.

Przyrostowe kopie zapasowe

Przyrostowe kopie zapasowe reprezentują najbardziej efektywną pod względem wykorzystania zasobów metodę tworzenia backup-ów, koncentrując się wyłącznie na danych, które zostały dodane lub zmodyfikowane od czasu ostatniej kopii zapasowej, niezależnie od jej typu. Ta charakterystyka czyni je najszybszą metodą backup-u w większości scenariuszy, ponieważ objętość danych do skopiowania jest zazwyczaj znacznie mniejsza niż w przypadku pełnych lub różnicowych kopii zapasowych. Przyrostowe backup-y są szczególnie wartościowe dla organizacji pracujących z dużymi bazami danych, gdzie codzienna modyfikacja dotyczy jedynie niewielkiej części całego zbioru informacji.

Mechanizm działania przyrostowych kopii zapasowych opiera się na śledzeniu zmian w systemie plików lub bazie danych od momentu wykonania ostatniego backup-u. Systemy te wykorzystują różne techniki identyfikacji zmienionych danych, włączając znaczniki czasowe modyfikacji plików, dzienniki transakcji bazodanowych lub specjalistyczne narzędzia monitorujące aktywność systemu. Każda przyrostowa kopia zawiera jedynie delta – różnicę pomiędzy aktualnym stanem danych a stanem z momentu poprzedniego backup-u, co skutkuje minimalnym wykorzystaniem przestrzeni dyskowej i pasma sieciowego.

Proces odzyskiwania danych z przyrostowych kopii zapasowych jest bardziej złożony w porównaniu z metodami alternatywnymi, wymagając sekwencyjnego przywrócenia pełnej kopii bazowej oraz wszystkich następujących po niej przyrostowych backup-ów w chronologicznej kolejności. Ta charakterystyka zwiększa ryzyko niepowodzenia procesu odtwarzania, ponieważ uszkodzenie którejkolwiek z kopii w łańcuchu może uniemożliwić kompletne przywrócenie danych. Dlatego też systemy wykorzystujące przyrostowe kopie zapasowe wymagają szczególnej uwagi w zakresie integralności i niezawodności wszystkich elementów łańcucha backup-ów.

Nowoczesne implementacje przyrostowych kopii zapasowych często wykorzystują zaawansowane algorytmy weryfikacji integralności oraz mechanizmy redundancji w celu minimalizacji ryzyka związanego z łańcuchową zależnością kopii. Niektóre systemy automatycznie konsolidują stare przyrostowe kopie z pełnymi backup-ami, tworząc nowe punkty odniesienia i skracając łańcuchy zależności. Te optymalizacje pozwalają na zachowanie głównych zalet przyrostowych kopii zapasowych przy jednoczesnym ograniczeniu ich potencjalnych wad.

Różnicowe kopie zapasowe

Różnicowe kopie zapasowe stanowią kompromis pomiędzy kompletnością pełnych backup-ów a efektywnością przyrostowych kopii, zapisując wszystkie dane dodane lub zmodyfikowane od czasu wykonania ostatniej pełnej kopii zapasowej. W przeciwieństwie do przyrostowych kopii, które odnoszą się do ostatniego backup-u niezależnie od jego typu, różnicowe kopie zawsze używają ostatniej pełnej kopii jako punktu odniesienia. Ta charakterystyka upraszcza proces odzyskiwania danych, wymagając jedynie przywrócenia ostatniej pełnej kopii oraz najnowszej kopii różnicowej, eliminując konieczność obsługi długich łańcuchów backup-ów.

Mechanizm działania różnicowych kopii zapasowych polega na ciągłym gromadzeniu wszystkich zmian wprowadzonych od momentu utworzenia bazowej pełnej kopii. W konsekwencji, każda kolejna różnicowa kopia jest większa od poprzedniej, ponieważ zawiera skumulowane modyfikacje z całego okresu od ostatniego pełnego backup-u. Rozmiar różnicowych kopii rośnie liniowo z czasem, co oznacza, że im dłuższy okres pomiędzy pełnymi kopiami zapasowymi, tym większe stają się kopie różnicowe. Ta właściwość wymaga starannego planowania harmonogramu backup-ów w celu optymalizacji wykorzystania zasobów.

Różnicowe kopie zapasowe oferują znaczące przyspieszenie procesu odzyskiwania danych w porównaniu z przyrostowymi backup-ami, ponieważ wymagają przywrócenia jedynie dwóch komponentów: pełnej kopii bazowej i najnowszej kopii różnicowej. Ta uproszczona procedura redukuje ryzyko błędów podczas odtwarzania oraz skraca czas potrzebny na przywrócenie systemu do stanu operacyjnego. Dodatkowo, mniejsza liczba elementów w procesie odzyskiwania oznacza niższe prawdopodobieństwo awarii związanych z uszkodzeniem którejś z kopii zapasowych.

Optymalne wykorzystanie różnicowych kopii zapasowych wymaga przemyślanej strategii dotyczącej częstotliwości tworzenia pełnych backup-ów. Zbyt długie okresy pomiędzy pełnymi kopiami prowadzą do nadmiernego wzrostu rozmiaru kopii różnicowych, podczas gdy zbyt częste pełne backup-y niwelują korzyści wynikające z tej metody. Współczesne systemy backup-u często implementują inteligentne algorytmy automatycznie optymalizujące harmonogramy w oparciu o wzorce zmian w danych oraz dostępne zasoby systemowe.

Lustrzane kopie zapasowe

Lustrzane kopie zapasowe reprezentują unikatowe podejście do ochrony danych, tworząc dokładną replikę zestawu danych źródłowych i utrzymując jej synchronizację z oryginałem w czasie rzeczywistym lub quasi-rzeczywistym. W przeciwieństwie do tradycyjnych metod backup-u, które przechowują dane w skompresowanych lub w inny sposób przetworzonych formatach, lustrzane kopie zachowują pliki w ich natywnej formie i oryginalnej strukturze katalogów. Ta charakterystyka umożliwia natychmiastowy dostęp do poszczególnych plików bez konieczności przeprowadzania formalnych procesów przywracania danych.

Mechanizm działania lustrzanych kopii zapasowych polega na ciągłej synchronizacji repozytorium kopii z danymi źródłowymi, automatycznie dodając nowe pliki, aktualizując zmodyfikowane elementy i potencjalnie usuwając pliki, które nie istnieją już w źródle. Proces synchronizacji może być realizowany w różnych trybach: ciągłym, zapewniającym niemal natychmiastową replikację zmian, lub okresowym, wykonującym aktualizacje według ustalonego harmonogramu. Kluczową cechą lustrzanych backup-ów jest ich skupienie na aktualnym stanie danych zamiast na przechowywaniu historycznych wersji, co odróżnia je od większości innych metod backup-u.

Główną zaletą lustrzanych kopii zapasowych jest ich wyjątkowa szybkość w procesach odzyskiwania danych oraz możliwość przełączania awaryjnego. Ponieważ dane są przechowywane w natywnym formacie i strukturze, systemy mogą być niemal natychmiast przełączone na kopię lustrzaną w przypadku awarii pierwotnego źródła. Ta właściwość czyni lustrzane backup-y idealnym rozwiązaniem dla systemów o krytycznym znaczeniu, gdzie minimalizacja przestoju ma pierwszorzędne znaczenie dla ciągłości działania organizacji.

Jednakże lustrzane kopie zapasowe posiadają również istotne ograniczenia, szczególnie w kontekście ochrony przed niektórymi typami zagrożeń. Ponieważ lustrzane kopie skupiają się na stanie bieżącym danych, a nie na zachowywaniu ich historycznych wersji, oferują ograniczoną ochronę w scenariuszach wymagających odzyskania danych z wcześniejszych punktów w czasie. Dodatkowo mechanizm synchronizacji, który zapewnia aktualizację kopii lustrzanej, może także niemal natychmiast przenieść na kopię niepożądane zmiany, takie jak uszkodzenie danych lub działania szkodliwe. Ta podatność wymaga rozważenia dodatkowych środków ochronnych przy wdrażaniu strategii backupu lustrzanego.

Zaawansowane strategie ochrony danych

Skuteczna ochrona danych wymaga zastosowania kompleksowych strategii wykraczających poza proste tworzenie pojedynczych kopii zapasowych. Zaawansowane podejścia do backup-u uwzględniają różnorodne scenariusze awarii, optymalizują wykorzystanie zasobów oraz zapewniają maksymalną dostępność danych w sytuacjach krytycznych. Te strategie łączą różne metody backup-u w spójne systemy ochrony, dostosowane do specyficznych wymagań organizacyjnych i technicznych.

Zasada 3-2-1

Zasada 3-2-1 stanowi powszechnie akceptowany standard w dziedzinie ochrony danych, zapewniający kompleksową strategię backup-u odporną na różnorodne scenariusze awarii. Nazwa tej zasady odzwierciedla jej trzy główne komponenty: utrzymywanie trzech kopii danych (włączając oryginalną), przechowywanie kopii na dwóch różnych typach nośników oraz lokalizowanie przynajmniej jednej kopii w zdalnej lokalizacji.

Pierwszy element zasady 3-2-1 wymaga utrzymywania trzech egzemplarzy krytycznych danych, z czego jeden stanowi wersję produkcyjną, a dwa pozostałe to kopie zapasowe. Ta redundancja znacząco redukuje prawdopodobieństwo całkowitej utraty informacji, ponieważ wymaga jednoczesnej awarii wszystkich trzech kopii. Dodatkowe kopie zapasowe zapewniają również elastyczność w procesach odzyskiwania, umożliwiając wybór najbardziej aktualnej lub najbardziej dostępnej wersji danych w zależności od okoliczności.

Drugi komponent zasady 3-2-1 koncentruje się na dywersyfikacji technologii przechowywania, wymagając wykorzystania przynajmniej dwóch różnych typów nośników danych. Ta różnorodność chroni przed awariami specyficznymi dla konkretnych technologii.

Trzeci element zasady 3-2-1 adresuje zagadnienie ryzyka związanego z lokalizacją, wymagając przechowywania co najmniej jednej kopii zapasowej w zdalnej lokalizacji. To wymaganie chroni przed katastrofami naturalnymi, pożarami, powodziami oraz innymi zdarzeniami mogącymi zniszczyć wszystkie kopie znajdujące się w jednym miejscu.

Nowoczesne interpretacje tej zasady rozwijają się w kierunku bardziej zaawansowanych strategii, takich jak 3-2-1-1-0, która dodaje wymagania dotyczące kopii offline oraz weryfikacji integralności danych. Te rozszerzenia adresują współczesne zagrożenia, takie jak ransomware i zaawansowane ataki cybernetyczne, które mogą wpływać na wszystkie kopie dostępne online. Implementacja zasady 3-2-1 wymaga starannego planowania i może wiązać się ze znacznymi kosztami.

Ciągła ochrona danych (CDP)

Ciągła ochrona danych, znana również jako CDP (Continuous Data Protection), reprezentuje najbardziej zaawansowaną formę backup-u, zapewniającą praktycznie natychmiastową ochronę wszystkich zmian wprowadzanych w systemie. W przeciwieństwie do tradycyjnych metod backup-u operujących według z góry określonych harmonogramów, CDP przechwytuje i zabezpiecza każdą modyfikację danych w momencie jej wystąpienia. Ta technologia umożliwia odzyskiwanie informacji z dowolnego punktu w czasie z dokładnością do pojedynczych transakcji.

Mechanizm CDP opiera się na przechwytywaniu operacji zapisu na najniższym poziomie systemu operacyjnego lub aplikacji, automatycznie zapisując każdą zmianę do dedykowanego repozytorium ochrony. System ten może działać w trybie synchronicznym, gdzie każda operacja zapisu jest jednocześnie replikowana do repozytorium CDP, lub asynchronicznym, gdzie zmiany są buforowane i okresowo transferowane do systemu ochrony. Synchroniczny tryb działania zapewnia najwyższy poziom ochrony, ale może wpływać na wydajność systemu produkcyjnego.

Kluczową zaletą CDP jest eliminacja okien czasowych, w których dane nie są chronione – problemu charakterystycznego dla tradycyjnych strategii backup-u. W systemach funkcjonujących według harmonogramów zawsze istnieje ryzyko utraty zmian wprowadzonych od ostatniego backup-u. CDP eliminuje to ryzyko, zapewniając, że maksymalna utrata danych (RPO – Recovery Point Objective) wynosi praktycznie zero.

Implementacja CDP wymaga znacznych zasobów obliczeniowych i może generować duże wolumeny danych ochrony, szczególnie w środowiskach o wysokiej aktywności transakcyjnej. Nowoczesne systemy CDP wykorzystują zaawansowane techniki optymalizacji, takie jak deduplikacja w czasie rzeczywistym, kompresja danych oraz inteligentne algorytmy retencji.

Technologie przechowywania kopii zapasowych

Wybór odpowiedniej technologii przechowywania kopii zapasowych ma kluczowe znaczenie dla skuteczności całej strategii ochrony danych. Współczesne organizacje mają do dyspozycji szerokie spektrum rozwiązań, od tradycyjnych lokalnych systemów po zaawansowane platformy chmurowe.

Lokalne rozwiązania backup-u

Lokalne systemy backup-u stanowią tradycyjny fundament strategii ochrony danych, oferując organizacjom pełną kontrolę nad procesami tworzenia, przechowywania i zarządzania kopiami zapasowymi.

- Dyski lokalne – stanowią najprostszą i najtańszą formę backup-u;

- Systemy NAS – umożliwiają scentralizowane zarządzanie kopiami wielu urządzeń w firmie;

- Dedykowane serwery backup-u – pozwalają na zarządzanie rozbudowaną infrastrukturą, monitoring statusu i automatyzację zadań.

Wadą lokalnych rozwiązań pozostaje podatność na te same zagrożenia, które dotyczą środowiska produkcyjnego oraz konieczność inwestowania i utrzymywania własnej infrastruktury.

Kopie zapasowe w chmurze

Backup w chmurze zmienia tradycyjne podejście do ochrony danych, oferując skalowalność, wysoką dostępność i zaawansowane mechanizmy redundancji oraz bezpieczeństwa. Kopie takie są przechowywane w geograficznie rozproszonych centrach danych, co zapewnia naturalną odporność na lokalne awarie.

- Model opłat za wykorzystane zasoby – pozwala na obniżenie kosztów początkowych;

- Dostępność automatycznych funkcji zarządzania cyklem życia danych – ułatwia optymalizację kosztów przechowywania;

- Możliwość integracji z aplikacjami biznesowymi – pozwala na wdrożenie backupu nawet w zaawansowanych środowiskach.

Krytyczne dla rozwiązań chmurowych jest bezpieczeństwo – nowoczesne platformy wdrażają szyfrowanie, zarządzanie kluczami i kontrolę dostępu oraz mechanizmy audytu zgodności.

Biblioteki taśmowe

Biblioteki taśmowe pozostają popularnym rozwiązaniem do długoterminowego backupu i archiwizacji z uwagi na niski koszt przechowywania dużych ilości danych przy wysokiej trwałości nośników.

- Bardzo niska cena jednostkowa miejsca na dane – opłacalność przy dużej liczbie backupów historycznych;

- Łatwa implementacja strategii offline – ochrona przed atakami ransomware;

- Automatyzacja obsługi – nowoczesne biblioteki wykorzystują robotykę i systemy śledzenia nośników.

Trwałość danych na taśmach magnetycznych sięga 30 lat, a systemy często stosują weryfikację integralności oraz predykcyjną diagnostykę stanu kaset.

Zarządzanie cyklem życia kopii zapasowych

Efektywne zarządzanie backupami obejmuje nie tylko ich tworzenie, lecz także implementację polityk retencji, kontrolę kosztów oraz zapewnianie zgodności z przepisami prawa i normami branżowymi.

Polityki retencji

Polityki retencji definiują, jak długo i gdzie przechowywane będą poszczególne kopie zapasowe. Umożliwiają segmentację backupów, różnicowanie czasu przechowywania w zależności od typu, kategorii i wartości danych.

- Backupy dzienne, tygodniowe, miesięczne oraz roczne – hierarchiczne przechowywanie danych dostosowane do potrzeb optymalizacji kosztowej;

- Automatyczna konsolidacja i przenoszenie backupów pomiędzy nośnikami – zgodnie z przyjętymi regułami retencji;

- Elastyczne zarządzanie – mechanizmy automatycznego usuwania przeterminowanych backupów i raportowania operacji.

Systemy pozwalają spełnić wymagania compliance oraz dokumentować procesy w audytach zewnętrznych.

Szyfrowanie danych

Szyfrowanie kopii zapasowych stanowi filar bezpieczeństwa chroniący informacje zarówno w czasie przechowywania, jak i transmisji. Najczęściej stosuje się algorytm AES-256, a systemy mogą korzystać z kluczy zarządzanych przez klienta lub dostawcę.

- Zarządzanie hierarchicznymi strukturami kluczy – umożliwia regularną rotację bez konieczności ponownego szyfrowania całych backupów;

- Integracja z usługami KMS – zapewnia compliance oraz end-to-end encryption;

- Weryfikacja integralności zaszyfrowanych kopii – wdrażanie funkcji hash i podpisów cyfrowych do zapewnienia niezmienności danych.

Deduplikacja

Deduplikacja optymalizuje pojemność magazynów backupu, eliminując występowanie powielonych fragmentów danych i tym samym znacznie obniżając zapotrzebowanie na przestrzeń dyskową.

- Deduplikacja na poziomie pliku oraz bloku – pierwszy typ eliminuje powielone pliki, zaawansowane systemy identyfikują nawet niewielkie fragmenty danych wspólne dla wielu kopii;

- Segmentacja bloków o zmiennej wielkości – zwiększa efektywność deduplikacji;

- Inline oraz post-process deduplikacja – rozwiązania działające w trybie rzeczywistym lub po wykonaniu backupu.

Testowanie i weryfikacja kopii zapasowych

Regularne testowanie i weryfikacja backupów są niezbędne, by organizacja miała gwarancję odtworzenia danych w momencie awarii. Testy powinny obejmować zarówno integralność danych, funkcjonalność odtworzeniową, jak i rzeczywistą gotowość zespołu IT.

Metodologie testowania

- Testy integralności – sprawdzają poprawność i możliwość odczytu danych z backupu;

- Testy funkcjonalne odtwarzania – weryfikują kompletność systemów oraz ich działanie po restarcie kopii;

- Testy wydajnościowe – mierzą czasy przywracania (RTO) i utraty danych (RPO);

- Testy scenariuszowe – symulują awarie i ataki, kontrolują procedury bezpieczeństwa w praktyce.

Automatyzacja procesów

Automatyzacja testowania kopii zapasowych zwiększa częstotliwość i skuteczność testów, minimalizując ryzyko błędów ludzkich. Zaawansowane systemy umożliwiają:

- Automatyczne testy integralności po każdym backupie – szybkie wykrywanie problemów i ponawianie kopii uszkodzonych;

- Zautomatyzowane testy przywracania w izolowanych środowiskach – regularne odtwarzanie systemów bez przerywania pracy produkcyjnej;

- Monitoring oraz raportowanie problemów – automatyzacja alertów i tworzenie narzędzi do analizowania wydajności procesu backupu.

Najlepsze praktyki ochrony danych

Najlepsza strategia backupu powinna być całościowo zintegrowana ze strukturą IT, odpowiadać specyfice biznesu, a także być dopasowana do zagrożeń i budżetu organizacji.

Integracja z infrastrukturą IT

Integracja backup-u z aktualną infrastrukturą IT gwarantuje skuteczność i minimalizuje ryzyka wynikające z niepełnej ochrony. Wymaga to zastosowania centralnego zarządzania, wsparcia dla różnych środowisk oraz możliwości automatyzacji.

- Zarządzanie centralne – kontrola polityk backupu z jednej konsoli;

- Integracja przez API – automatyzacja powiązań z narzędziami ITSM, zarządzaniem siecią lub procesami orkiestracji;

- Optymalizacja sieciowa – stosowanie mechanizmów QoS i zarządzania ruchem backupów.

Optymalizacja kosztów i wydajności

Optymalizacja kosztów backupów polega na dostosowaniu poziomu zabezpieczenia do wartości biznesowej danych i możliwości finansowych firmy.

- Storage tiering – automatyczne przenoszenie backupów na tańsze lub szybsze nośniki zgodnie z analizą wzorców dostępu;

- Wykorzystanie elastyczności chmury – dynamiczne skalowanie zasobów, korzystanie z modeli opłat za rzeczywiste użycie;

- Optymalizacja wydajności – przetwarzanie równoległe, harmonogramy backupów i automatyzacja zarządzania zasobami.

Jak zamknąć program skrótem klawiszowym – skuteczne sposoby dla Windows i Mac

Plik DAT: jak otwierać, konwertować i bezpiecznie używać w różnych systemach

Jak naprawić błąd „nie znaleziono punktu wejścia procedury” i zapobiegać mu w przyszłości

Jak analizować filmy? Przewodnik dla początkujących kinomanów

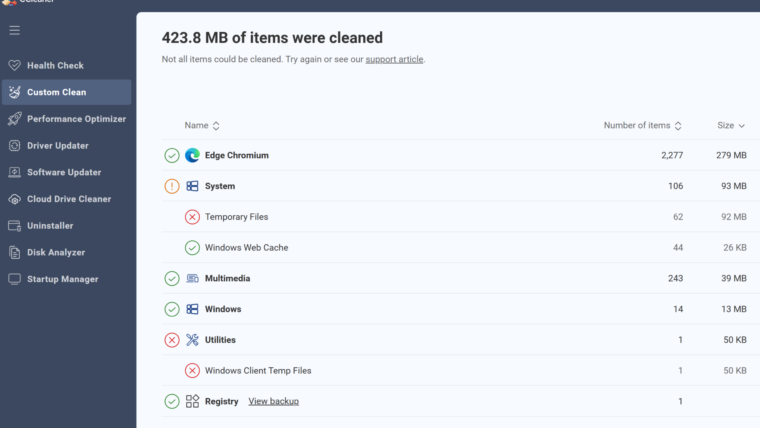

Jak działa CCleaner? Czy jest bezpieczny? Przegląd możliwości i funkcji

Skuteczne wdrożenie Magento 2 – jak zbudować sklep, który naprawdę sprzedaje

Optymalna produkcja — jak wesprzeć procesy w swojej firmie?

192.168.1.1 – co to? Jak się zalogować?